kuboard部署java项目(手动版)

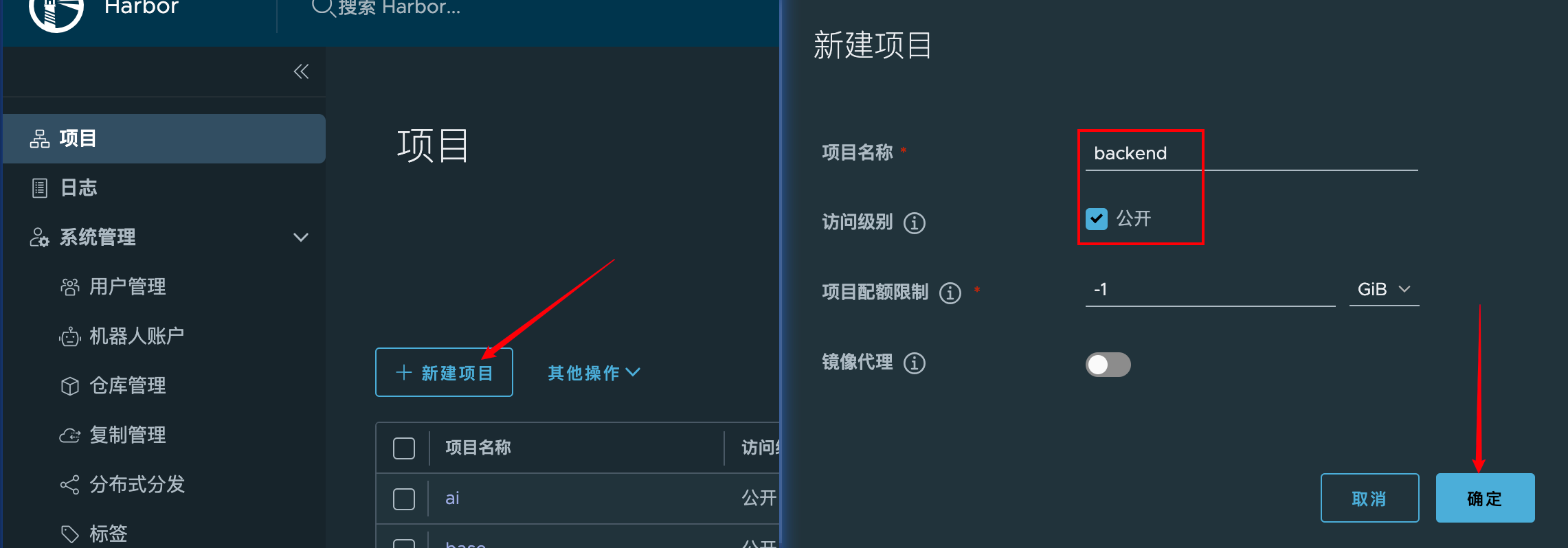

创建harbor项目(已有项目可以忽略)

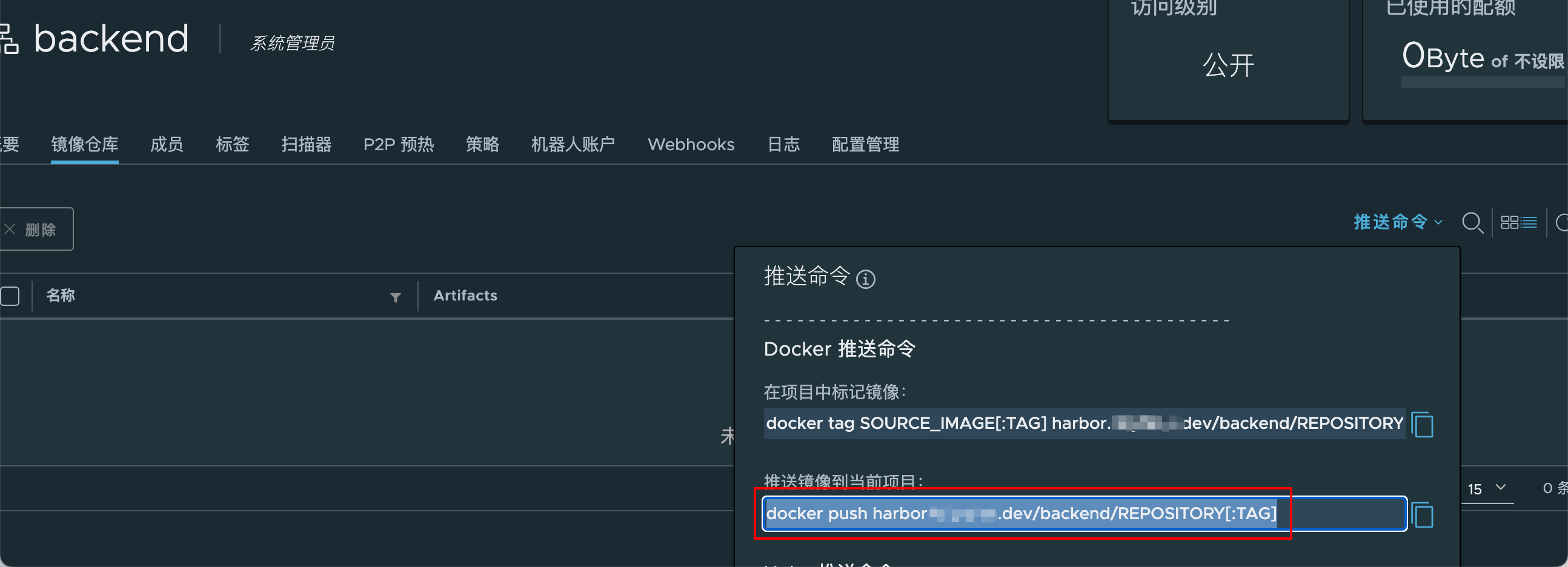

查看推送命令,得到镜像名称格式

harbor.xxxtech.dev/backend/REPOSITORY[:TAG]

配置hos映射,将

harbor.xxxtech.dev域名映射到172.16.10.49主机上(后期域名可直接访问省略这一步)打包java项目,构建docker镜像,执行命令

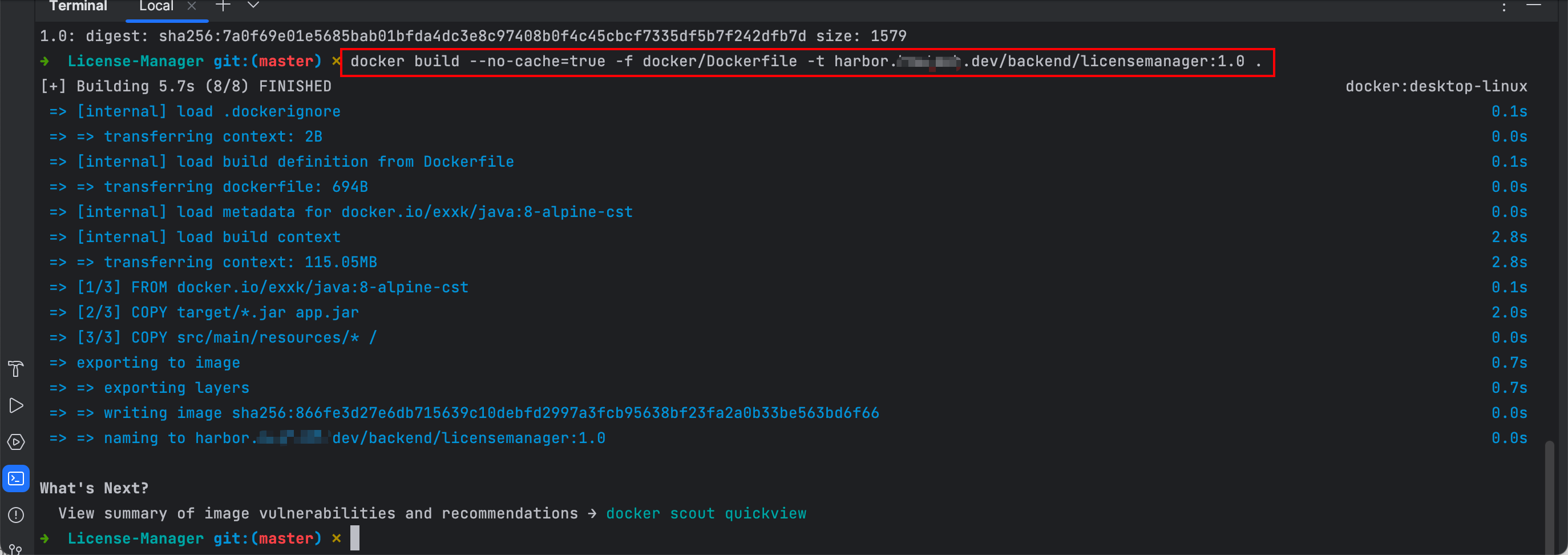

docker build --no-cache=true -f [Dockerfile的路径] -t harbor.xxxtech.dev/backend/[项目名]:[TAG] [指定目录构建]Eg:

docker build --no-cache=true -f docker/Dockerfile -t harbor.xxxtech.dev/backend/licensemanager:1.0 .

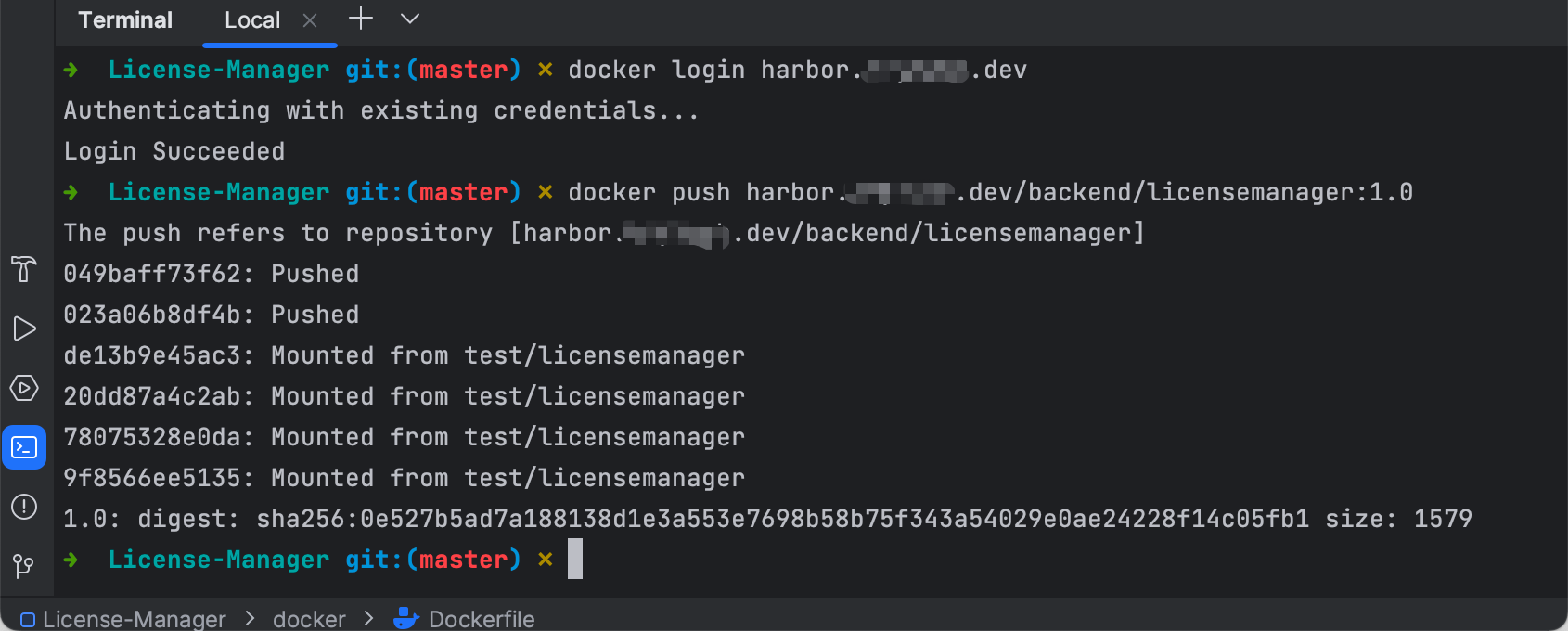

推送镜像到Harbor。

1

2

3

4

5

6#修改 Docker daemon的配置文件,添加如下配置

"insecure-registries": [ "harbor.xxxtech.dev" ]

#根据提示输入用户名和密码

docker login harbor.xxxtech.dev

#推送镜像

docker push harbor.xxxtech.dev/backend/licensemanager:1.0

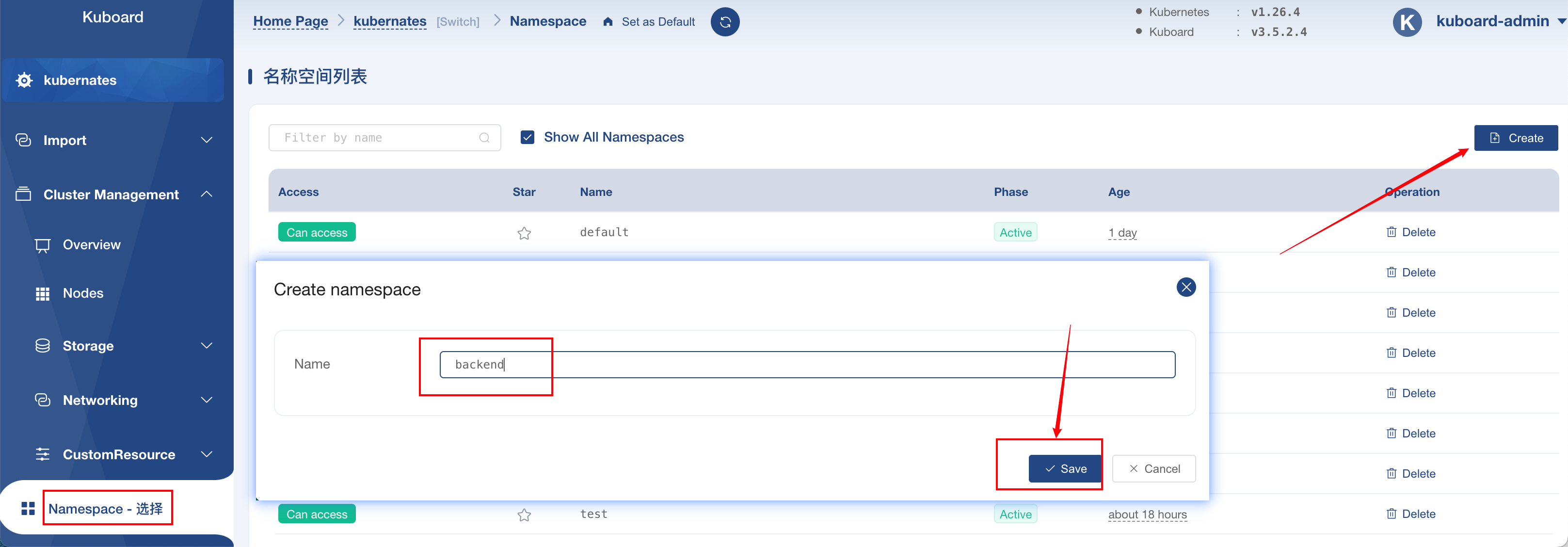

登录kuboard创建命名空间(存在可以忽略该步骤)

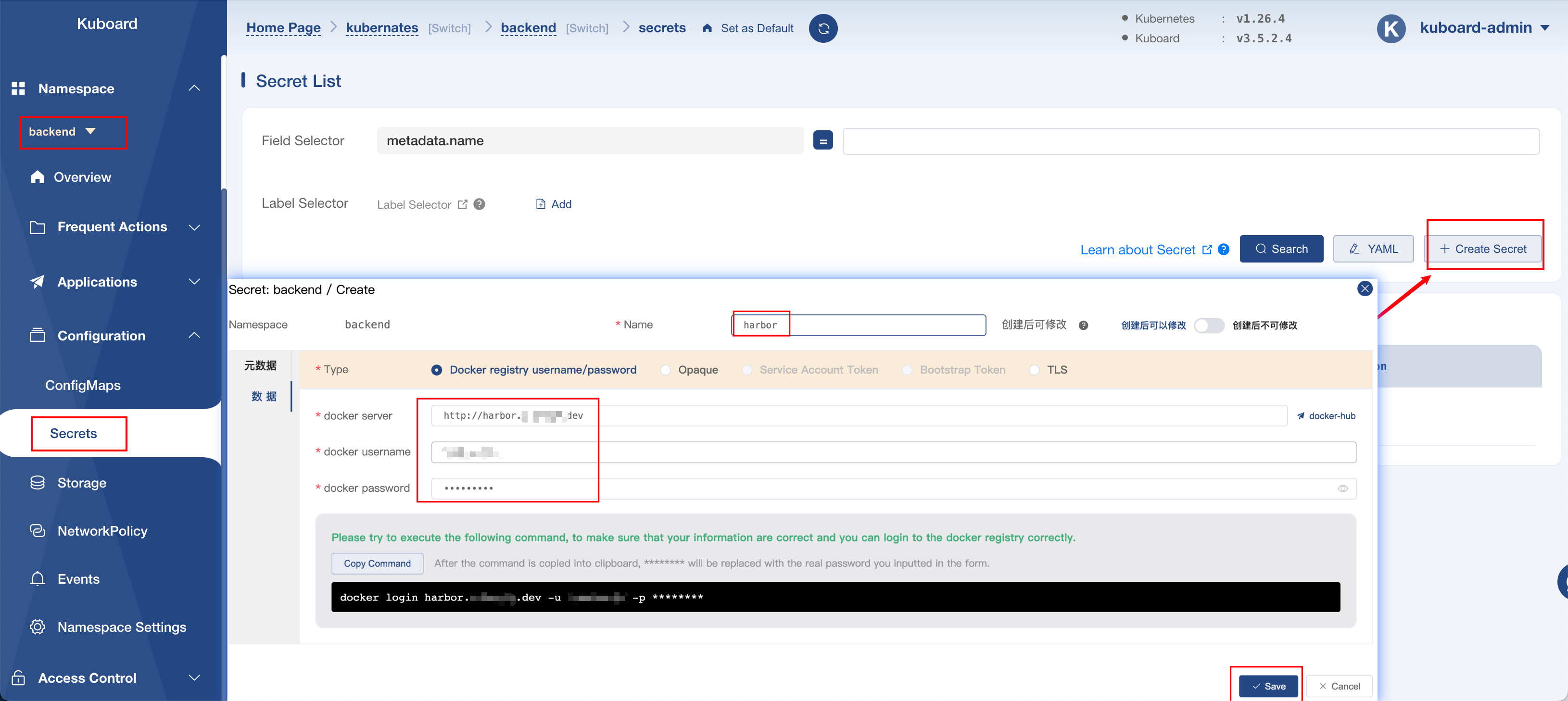

配置harbor仓库(已配置可以忽略该步骤)

输入docker server:http://harbor.xxxtech.dev

输入docker username:对应harbor的用户名

输入docker password:对应harbor的密码

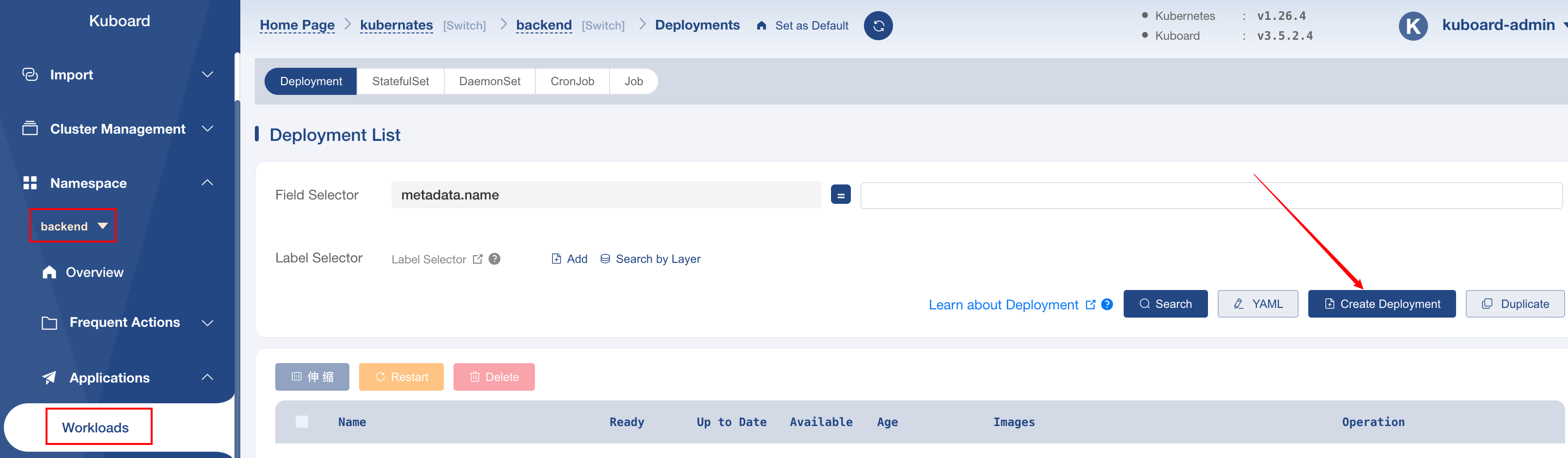

开始部署项目,创建Deployment

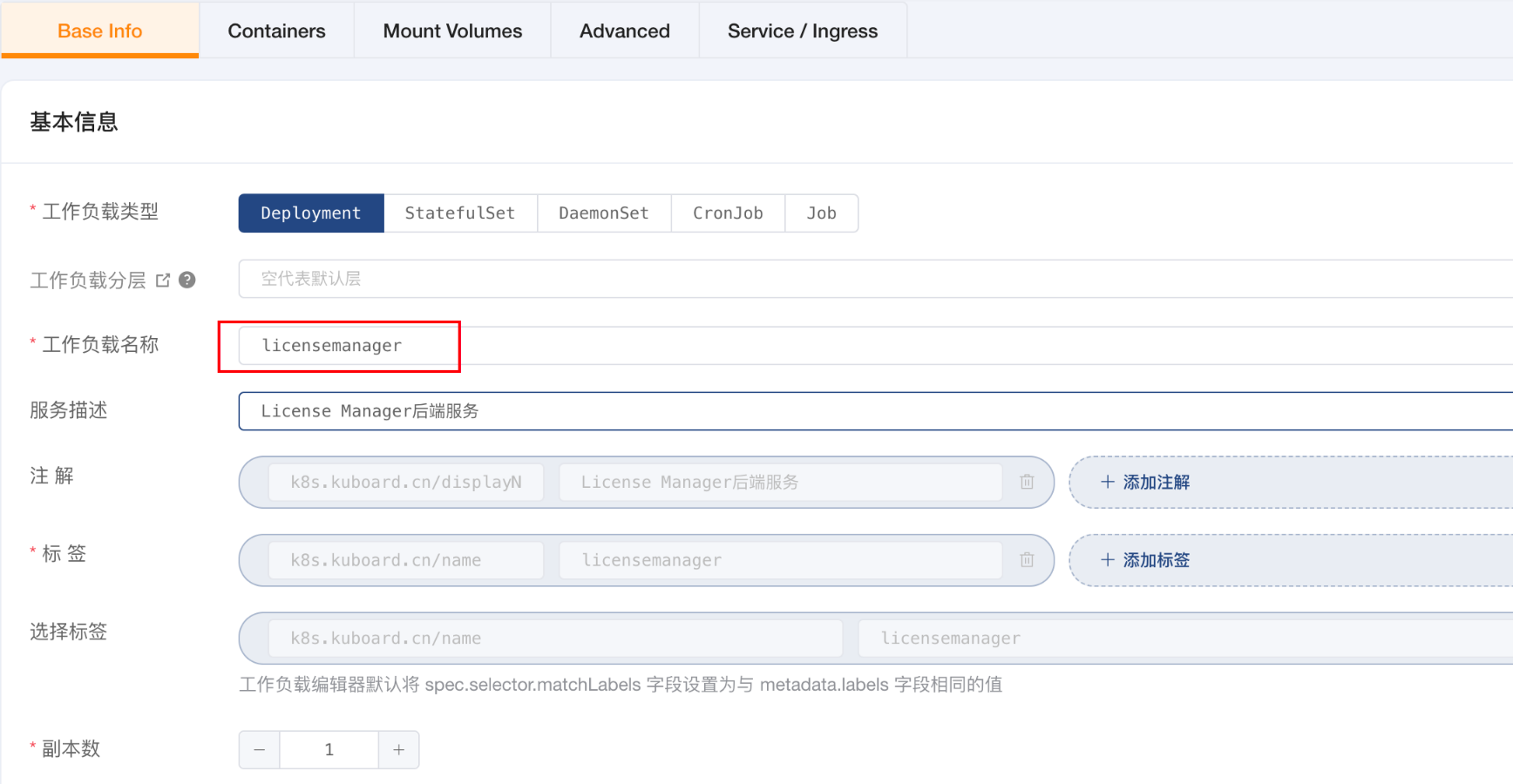

设置工作负载名称,副本数默认1即可,生产按需进行增加副本

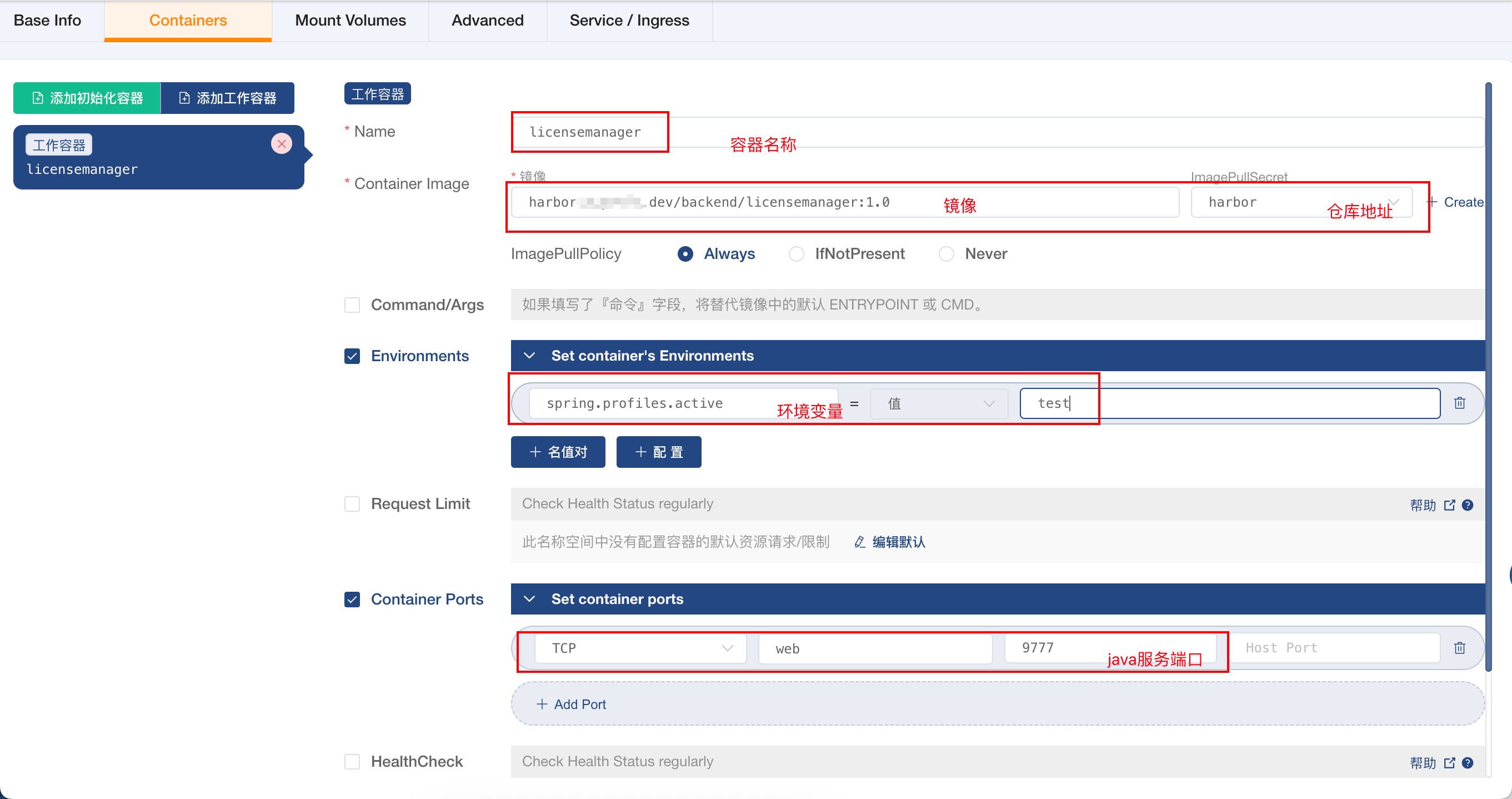

添加工作容器

可选:添加两个健康检查接口

/actuator/health/liveness和/actuator/health/readiness

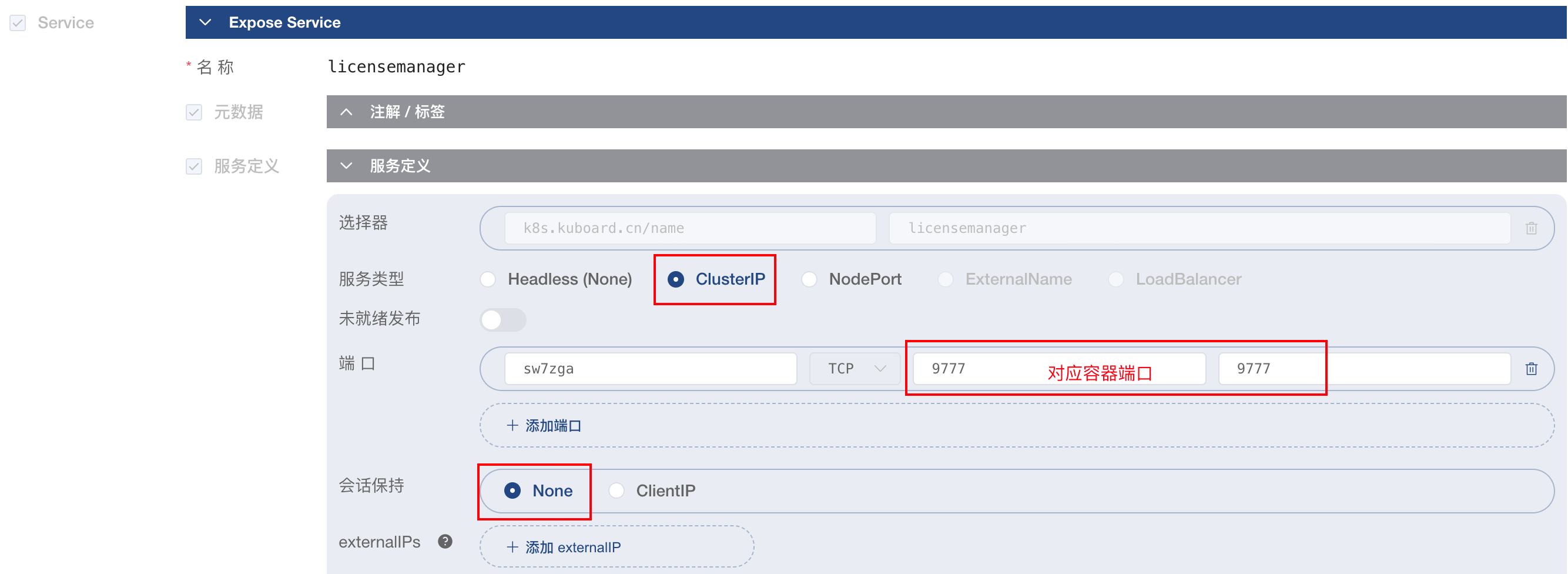

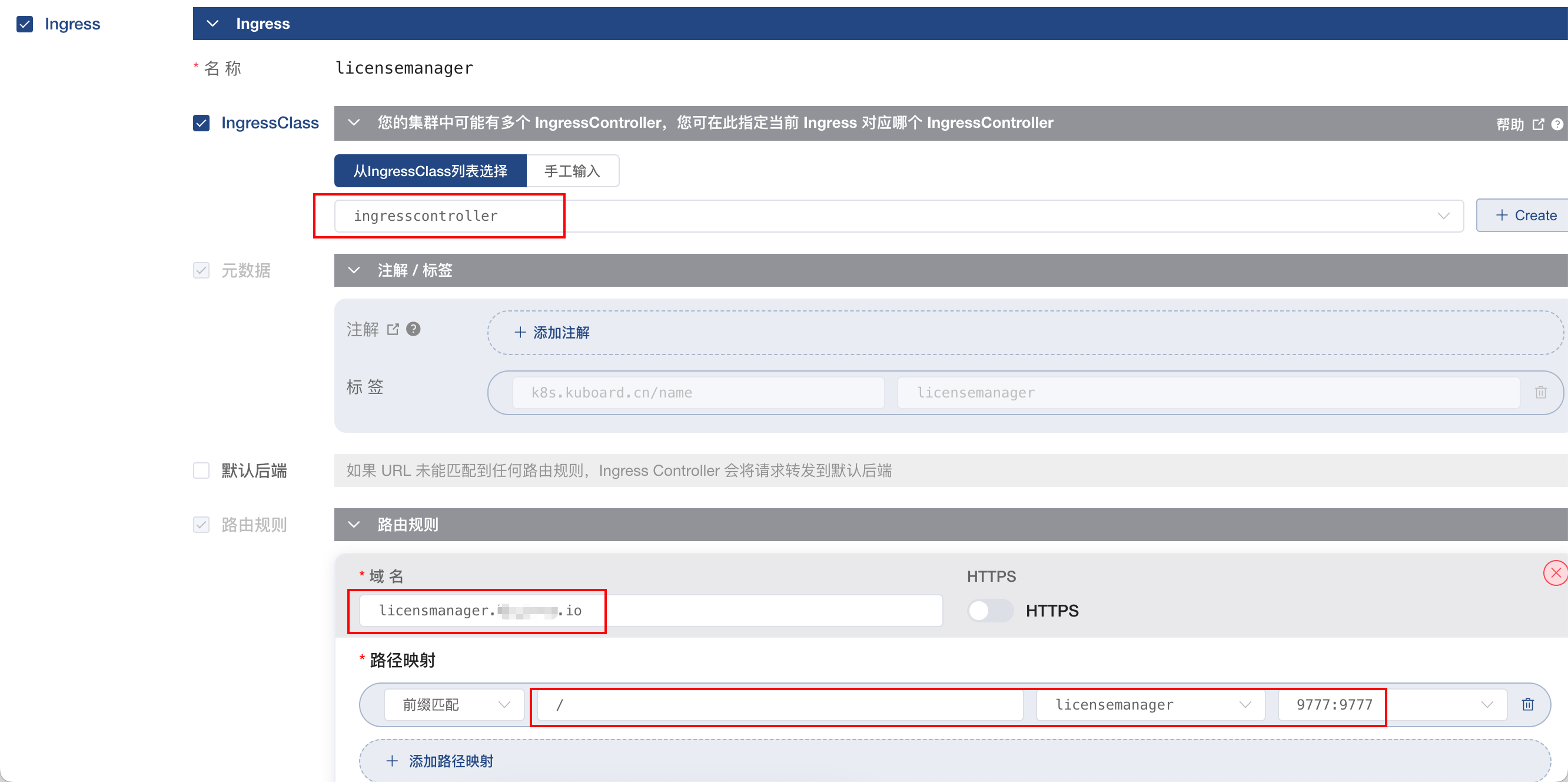

配置访问地址ingress

配置nginx进行访问(这一步有公共nginx可以省略)

运行nginx:

docker run --name xxx-nginx -v /Users/xuanleung/xxx/nginx.conf:/etc/nginx/conf.d/default.conf:ro -p 80:80 -d nginx1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16server {

listen 80;

server_name .xxxtech.io;

#access_log /var/log/nginx/hoddst.access.log main;

location / {

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_pass http://172.16.10.44:31407/;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

}在host添加域名映射:

127.0.0.1 licensmanager.xxxtech.io